智能汽车智能驾驶升级是靠通用传感器的关键综合感知作用吗

智能汽车智能驾驶升级中,通用传感器扮演着综合感知核心角色。它们通过多模态数据融合,突破单一传感器局限,实现环境精准建模。在复杂交通场景下,传感器协同工作可提升决策可靠性,为自动驾驶安全与效率提供技术支撑。

探秘智能驾驶升级:通用传感器的综合感知密码

当智能汽车驶向未来,自动驾驶技术正从辅助驾驶向更高等级自动化跃迁。在这场技术革命中,一个关键问题浮出水面:如何让车辆在复杂环境中获得“超人类感知”?答案藏在通用传感器的综合感知体系中——这些精密装置通过多模态数据融合,构建起车辆对周围世界的立体认知,成为智能驾驶安全与效率的核心保障。

一、单一传感器的“感知困境”:为何需要综合感知?

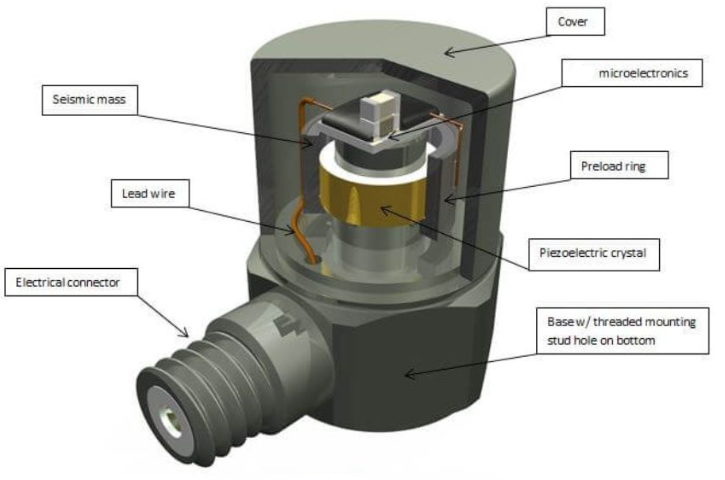

在智能驾驶系统中,每种传感器都有其独特优势:摄像头擅长捕捉视觉信息,激光雷达可生成高精度三维点云,毫米波雷达能穿透恶劣天气探测目标,超声波雷达则精于近距离障碍物检测。然而,单一传感器的局限性同样明显——摄像头在强光或逆光环境下易失效,激光雷达对雨雪天气敏感,毫米波雷达难以识别物体形状。这种“感知盲区”在复杂交通场景中可能引发致命风险:例如,暴雨中摄像头无法识别交通标志,而毫米波雷达可能将路面积水误判为障碍物。

技术突破点:通过多传感器数据融合,系统可交叉验证感知信息。当激光雷达检测到前方障碍物时,摄像头同步识别其类别(如行人或车辆),毫米波雷达则提供速度数据,三者协同构建起更完整的场景模型。

二、综合感知的“技术融合”:如何实现1+1>2?

通用传感器的综合感知并非简单叠加,而是通过硬件协同与算法优化实现深度融合。在硬件层面,传感器需满足时空同步要求:激光雷达与摄像头的安装位置需经过精密校准,确保两者视角重叠区域的数据对齐;时钟同步技术则保证所有传感器在同一时间基准下工作,避免因时间差导致的位置误差。

算法层面,融合技术分为三个层级:

数据层融合:直接合并原始数据,生成更密集的点云或图像,但计算量巨大;

特征层融合:提取各传感器数据的特征(如边缘、运动轨迹)后再融合,平衡效率与精度;

决策层融合:各传感器独立分析后,通过加权投票或贝叶斯网络等算法生成最终决策,适用于高可靠性场景。

典型应用:在自动泊车场景中,超声波雷达探测车位边界,摄像头识别地面标线,激光雷达扫描周围障碍物,系统综合三者数据规划最优路径,即使光线昏暗或车位标识模糊也能精准操作。

三、未来演进:综合感知的三大方向

随着技术迭代,通用传感器的综合感知能力正向三个维度延伸:

多模态深度融合:引入红外传感器、事件相机等新型设备,增强对极端天气或低光照环境的适应能力;

边缘计算赋能:在传感器端集成轻量级AI芯片,实现数据预处理,减少传输延迟;

车路协同扩展:通过V2X技术融合路侧传感器数据,构建“全局感知网络”,突破单车感知范围限制。

技术挑战:如何平衡传感器成本与性能?当前,固态激光雷达、4D毫米波雷达等新型设备正通过芯片化设计降低成本,而多传感器冗余设计则通过算法优化减少硬件数量,为大规模商业化铺平道路。

常见问题解答

Q1:综合感知系统能否完全替代人类驾驶员?

A:目前技术仍需人类监督。综合感知可处理90%以上常规场景,但在极端天气或突发状况下,人类驾驶员的应急判断能力仍不可替代。

Q2:多传感器融合会显著增加车辆成本吗?

A:随着技术成熟,传感器成本正快速下降。例如,固态激光雷达价格已降至传统机械式的十分之一,而算法优化也减少了硬件冗余需求。

Q3:综合感知系统如何应对传感器故障?

A:系统通过冗余设计实现“降级运行”。例如,当激光雷达失效时,摄像头与毫米波雷达可接力完成基础感知,同时触发警报提示驾驶员接管。

Q4:未来传感器融合会向哪些新领域拓展?

A:车路协同与空天地一体化感知是重点方向。通过融合路侧单元、卫星导航甚至无人机数据,系统可实现跨区域、全场景的感知覆盖。

本文总结

通用传感器的综合感知是智能驾驶升级的核心引擎。通过多模态数据融合与算法优化,系统突破了单一传感器的物理局限,构建起立体、动态的环境认知模型。随着技术向多模态融合、边缘计算和车路协同方向演进,智能汽车将逐步具备“超人类感知”能力,为自动驾驶的安全性与可靠性提供坚实保障。这一进程不仅重塑了出行方式,更推动了整个交通生态向智能化、协同化方向转型。